Fajnym programem wspomagającym tworzenie haseł jest apg. Pozwala on w szybki sposób wygenerować dobre hasła. Dobrym zwyczajem jest użyć przełączników określających długość hasła -m (minimalna długość) i (-x – maksymalna długość) oraz reguł co hasło ma zawierać czyli -M (L – małe litery, -C duże litery oraz -N liczby).

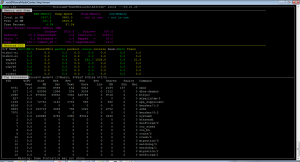

Przykład użycia:

# apg -M LCN -m 32 -x 32 cawOvperAphfavsierpOcsherpizDav1 TothujfomisebciTwatdeshkOtguzeb4 TijabKitnejdudTakucsyegnedNasht9 snesAlpyidcus4krepJokyalshOvonyu pokDuAriddyatsUmtolIafsinPanhif5 InonAkpiedribvolfoddIfNifHykDig0